Hace solo un par de dias se lanzó vSphere 5, y en este blog publiqué un resumen de lo nuevo que viene en vSphere 5.

En esta ocasión, veremos más en profundidad las mejoras que incluye vSphere 5 desde el punto de vista del Almacenamiento.

VMFS-5

vSphere 5 trae una nueva versión de su sistema de archivos VMFS, el cual contiene importantes cambios y mejoras en su arquitectura, mejorando la escalabilidad y performance respecto a la versión anterior, VMFS-3.

vSphere incluye mecanismos para la migración de VMFS-3 a VMFS-5 en un proceso consistente sin interrupciones. Durante el proceso de Upgrade, los volumenes migrados a VMFS-5 mantendrán el Block Size configurado, debido a que modificar este parametro requeriría formatear el volumen.

VMFS incluye las siguientes mejoras:

- Soporte de dispositivos de hasta 64TB. Una gran mejora considerando el limite de 2TB impuesto en VMFS-3 (sin considerar los extents)

- Block Size unificado de 1MB, que reduce la complejidad desde el punto de vista de la arquitectura y la operacion, mientras aun se mantienen la escalabilidad y flexibilidad que existia previamente con Block Sizes más grandes.

- Mecanismo mejorado de Sub-bloques. Permite una mayor escalabilidad, reduciendo el overhead asociado con los archivos pequeños. VMFS-5 es capaz de asignar hasta 30.000 sub-bloques de 8KB para archivos como archivos de Logs y metadata (Ej. archivos .vmx).

A continuación una cuadro que nos permite comparar los cambios en la arquitectura entre VMFS-3 y VMFS-5

Todo esto permite soportar volumenes más grandes, de hasta 64TB, y una mayor densidad de máquinas virtuales.

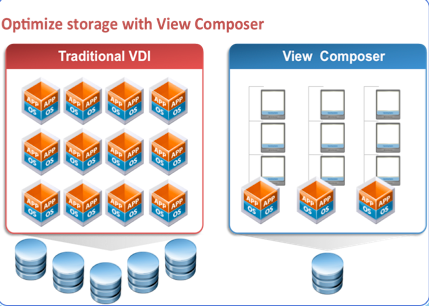

Storage DRS

Un desafio permamente en una infraestructura virtual, es el monitoreo de la capacidad de los datastores, y de la carga de I/O.

Durante la creación de MV y Virtual Disks, es frecuente ver que la selección de cual Datastore utilizar está dado por una selección aleatora, lo cual puede llevar a una sobreutilización de algunos datastores, mientras otros practicamente no son utilizados.

Para enfrentar estos desafios, vSphere 5 incluye una caracteristica llamada Storage DRS, la cual provee de una asignación inteligente de datastore para las máquinas virtuales, y mecanismos de balanceo de carga entre los datastores, basados en espacio disponible y en capacidad de I/O.

Se crea un nuevo objeto de inventario en vCenter, llamado Datastore Cluster, el cual es la base de Storage DRS. Un Datastore Cluster es un conjunto de datastores agrupados en una unica unidad.

Cuando se crea un Datastore Cluster, sDRS puede gestionar los recursos de almacenamiento en forma similar a como DRS gestiona los recursos de CPU y Memoria en un cluster.

Respecto a las recomendaciones de ubicación inicial para las MV provistas por Storage DRS, al momento de crear una MV, se puede seleccionar un Datastore Cluster como la ubicación para la MV y/o Virtual Disks, en vez de la seleccion de Datastore individual que se realizaba tradicionalmente. Storage DRS se asegura además que la ubicación inicial de las MV esté acorde con la utilización actual de los Datastores, y la carga de I/O en cada uno de estos, reduciendo el riesgo de cuellos de botella en las operaciones de I/O, y el consiguiente impacto en la performance de las máquinas virtuales.

Respecto a las recomendaciones de balanceo de carga, estas son hechas cuando uno o más datastores en un Datastore Cluster, exceden los umbrales previamente definidos en la utilización de espacio, o en la latencia de las operaciones de I/O (15ms por defecto). Estos Umbrales son definidos durante la creación del Datastore Cluster, y pueden ser modificados en el tiempo.

Para realizar recomendaciones, sDRS aplica los mecanismos de reporte de utilización de Datastores provistos por vCenter Server (y que ya estaba disponible en vSphere 4), a la vez que la carga de I/O es evaluada, por defecto, cada 8 horas. Cuando uno de los umbrales es superado, sDRS calcula todos los movimientos posibles para balancear la carga, considerando ademas el costo y beneficio de dichas migraciones.

Storage DRS incluye además, asi como el DRS tradicional, reglas de afinidad y anti-afinidad, asi como el uso del Modo de Mantenimiento. Esto permite controlar cuales virtual disks debieran o no ser ubicados en el mismo datastore en un Datastore Cluster. Por defecto, los virtual disks de una VM son mantenidos juntos en el mismo Datastore. Storage DRS ofrece 3 tipos de reglas de afinidad.

- Anti-Afinidad de VMDK, donde una los Virtual Disks de una MV son ubicados en diferentes datastores.

- Afinidad de VMDK, donde los virtual disks de una MV son mantenidos juntos en un mismo datastore

- Anti-afinidad de VM, donde 2 MV especificas, incluyendo sus Virtual Disks, son ubicadas en diferentes datastores.

Adicionalmente, Storage DRS ofrece el Modo de Mantenimiento de un Datastore, el cual permite liberar un Datastore especificado, de todas las MV y Virtual Disks que este contenga, a los datastores restantes en el Datastore Cluster.

Storage DRS funciona con Datastores VMFS y NFS, pero estos no pueden ser mezclados en un unico Datastore Cluster.

vSphere Storage APIs - Storage Awareness

Es un nuevo conjunto de APIs que le permite a vCenter Server detectar las capacidades de los datastores/LUNs del arreglo de Storage, haciendo mucho más facil seleccionar el datastore para la ubicación inicialde una MV, o incluso facilitando el proceso de creación de un Datastore Cluster.

Las capacidades del Storage, como el nivel de RAID, Thin o Thick Provisioning, Replicación, etc., es visible dentro de vCenter Server utilizand estas APIS.

Profile-Driven Storage

Permite una ubicación rapida e inteligente de una MV en un Datastore, basado en SLAs, Disponibilidad, Performance u algún otro requisito.

Usando Profile-Driven Storage, diferentes capas, o Tiers, pueden ser requeridos por un perfil de storage de una MV. Estos perfiles son usados durante la provisión de una MV, durante el clonado, y durante las operaciones de Storage vMotion, asegurandose que solo aquellos Datastores o Datastores Clusters que cumplen con el perfil de storage de la VM, se encuentran disponibles para dicha VM.

Con esto, uno puede definir una serie de perfiles (tiers) de MV, cada uno con ciertas caracteristicas de Disponibilidad, Performance, Capacidad, Costo, etc., y aplicarlos a diferentes MV automatizando la selección del Datastore a utilizar, y asegurando que dichas MV solo utilicen Datastores o Datastore Clusters que cumplan con dicho perfil.

Profile-Driven Storage se integra completamente con "vSphere Storage APIs - Storage Awareness", e incluye soporte para Storage NFS, iSCSI y FC que se encuentren en la HCL.

vCenter Server permite además un chequeo sencillo del estado de cumplimiento de las máquinas virtuales y sus virtual disks asociados.

Como resultado, la gestion de capas (tiers) de storage, el provisionamiento, migración, clonación y ubicación inicial de MV en vSphere, se ha vuelto más eficiente y más amigable.

Iniciador por software para Fibre Channel over Ethernet (FCoE)

Si bien vSphere 4 ya soportaba FCoE, vSphere 5 da un paso más allá introduciendo un adaptador FCoE por software, equivalente al iniciador iSCSI por Software.

El adaptador FCoE por software requiere de un adaptador de red que soporte capacidades parciales de FCoE offload.

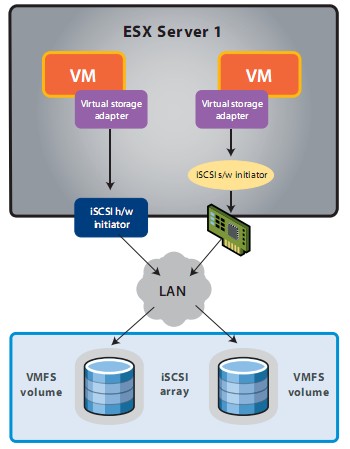

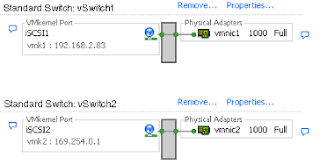

Mejoras en el iniciador iSCSI

Si bien con vSphere 4, el iniciador iSCSi por software fue completamente rescrito y optimizado por performance, la configuración solo era posible a traves de la linea de comandos, y era considerada una tarea "dificil" =D

Para enfrentar esto, vSphere 5 incluye la posibilidad de configurar iSCSI completamente a través de vSphere Client. Incluso la habilitación de Jumbo Frames es ahora posible de realizar utilizando vSphere Client.

vSphere Storage I/O Control

En vSphere 4 se introdujo inicialmente esta funcionalidad para proveer de priorización de I/O de MV corriendo en un cluster VMware, que tenia acceso a almacenamiento compartido iSCSI o FC. Este tipo de control estaba basado en Shares y limites, muy similar a lo que existe para el control de los recursos de CPU y Memoria.

vSphere 5 extiende esta funcionalidad para proveer de Shares y limites de I/O para datastores VMFS. Con esto podriamos lograr que ninguna MV sea capaz de crear un cuello de botella en un ambiente VMware, sin importar el tipo de almacenamiento utilizado.

vSphere Storage APIs – Array Integration

VAAI fue incluido ya en vSphere 4.1 permitiendo liberar al hypervisor de operaciones como:

- Full Copy, permitiendo que el Storage haga las copias completas dentro del arreglo.

- Block Zeroing, permitiendo al arreglo ejecutar operaciones de Zeroing en un gran numero de bloques

- Locking asistido por hardware, lo que provee de un mecanismo alternativo para proteger la metadata de VMFS.

En vSphere 5.0, el soporte VAAI ha sido mejorado adicionado nuevas capacidades:

- vSphere Thin Provisioning, permitiendo la reclamación del espacio no utilizado cuando un archivo es borrado o removido del datastore con Storage vMotion, y el monitoreo del espacio usado por LUNs con Thin Provisioning, evitando situaciones en que una LUN se pueda quedar sin espacio debido a la sobresuscripción de Storage.

- Aceleracion de hardware para NAS, lo cual permitirá un provisionamiento más rapido, y el uso de Virtual Disks en formato Thick (en vSphere 4 un Virtual Disk en un Storage NAS era creado con Thin Provisioning por defecto, no permitiendo el uso de discos Thick) utilizando dos nuevas funcionalidades VAAI:

- Full File Clone, similar a Full Copy, que permite que los virtual disks sean clonados en un dispositivo NAS.

- Espacio Reservado, que permite la creación de virtual disks en formato Thick en una NAS.

- Estandarizacion SCSI para cumplimiento de T10 para Full Copy, Block Zeroing y Locking asistido por Hardware.

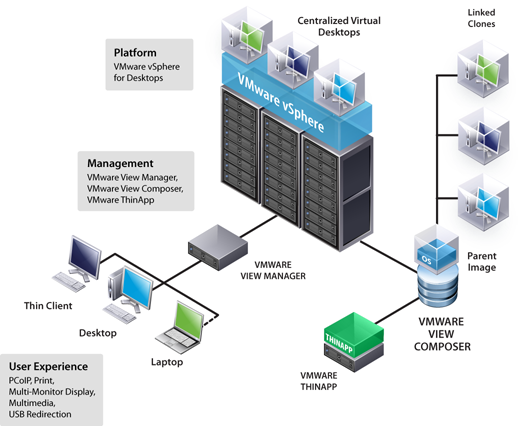

vSphere Storage vMotion

Incluido inicialmente en vSphere 4, permite la migración en caliente de los discos virtuales de una MV desde un datastore a otro, sin downtime o perdida de servicio.

vSphere 5 ha incluido una serie de mejoras para que el proceso de Storage vMotion sea mas eficiente, permitiendo ademas la migración de MV que contengan Snapshots, y la migración de Linked Clones (View, Lab Manager).

Storage vMotion en vSphere 5 incluye un nuevo proceso de migración a traves del uso de una caracteristica llamada Mirror Mode, la cual permite una copia de bloques desde el disco de origen al disco de destino, espejando los I/Os de bloques copiados. Esto mejora la eficiencia de Storage vMotion, logrando además que los tiempos de migración sean predecibles, facilitando la planificación de las migraciones.

El mirror driver se habilita por MV y reside dentro del VMKernel Cuando el sistema operativo en la máquina virtual que está siendo migrada con Storage vMotion, inicia una operacion de escritura a un bloque ya copiado, el Mirror Driver espejara en forma sincrona esta operacion de escritura.

Espero que les haya sido de utilidad, y les haya aclarado un poco sobre las nuevas funcionalidades de vSphere 5 enfocadas al Almacenamiento.